Reliabilitäten berechnen mit SPSS

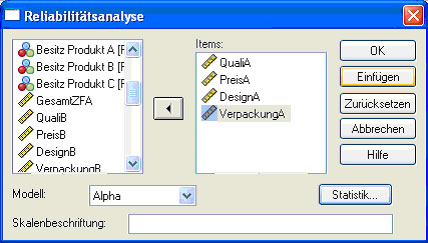

Diese Funktion braucht man für die Überprüfung der Reliabilität einer Skala. Unter Reliabilität versteht man den Grad der Zuverlässigkeit oder Genauigkeit mit der ein Erhebungsinstrument funktioniert. Man findet diese Funktion unter dem Menüpunkt „Analysieren“/„Skalieren“/„Reliabilitätsanalyse“. Im dort erscheinenden Fenster (Abb. 16) gibt man alle Variablen (z.B. „Fröhlichkeit“ und „Traurigkeit“) ein, die zu einer Skala (z.B. „Stimmung“) gehören. Im Auswahlmenü „Modell“ gibt man an, welche Art von Relibilitätsanalyse man vornehmen will. Standardmäßig ist „alpha“ eingestellt. Gemeint ist damit eine interne Konsistenzanalyse oder auch Inter-Item-Reliabiltät. Unter „Statistik“ kann man auswählen, welche Kennzahlen man haben möchte. Man sollte sich auf jeden Fall die Korrelation der Items untereinander anzeigen lassen, auch die deskriptiven Maße sind oft nützlich.

Abb.16

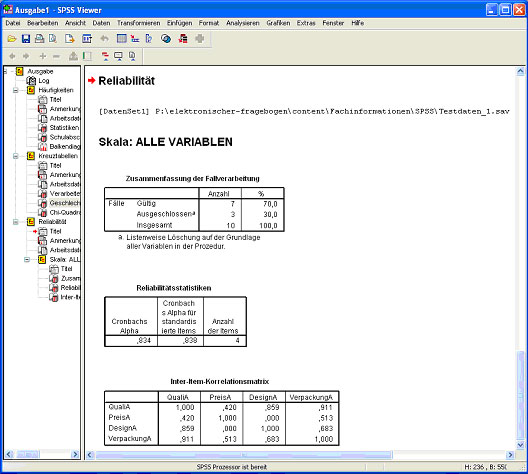

In der Ausgabe (Abb. 17) bekommt man zunächst wieder Informationen über die verwendeten Variablen. Die Anzahl der ausgeschlossenen Fälle gibt darüber Aufschluss, wie viele Datensätze aufgrund von fehlenden Daten nicht mit in die Analyse aufgenommen wurden. Listenweiser Ausschluss bedeutet, dass bei einem fehlenden Wert die Person überhaupt nicht aufgenommen wurde, Fallweiser Ausschluss bedeutet, dass die Daten der Person in der Berechnung der Zusammenhänge für die fehlende Variable nicht benutzt wurden, für andere Zusammenhänge aber schon.

In der Tabelle darunter erhält man Auskunft über die Reliabilitätsstatistik Cronbachs Alpha. Cronbachs Alpha bezeichnet das Maß für die Stärke der Inter-Rater-Reliabilität oder internen Konsistenz. Der Wert dieser Statistik schwankt zwischen 0 und 1, dabei gilt: je höher desto besser, d.h. je höher der Wert für Cronbachs Alpha, desto genauer misst das Erhebungsinstrument. Als Faustregel kann man sich dabei merken, dass ein Wert größer 0,7 als akzeptabel gilt, ein Wert größer 0,8 gilt als gut. Ein Wert größer 0,9 ist „ein Traum“.

Darunter bekommt man, wenn vorher angefordert, die statistischen Kennwerte der Verteilung der Antworten für einzelne Items. Anschließend erhält man eine Tabelle mit den Korrelationen der einzelnen Items untereinander. Ein Item dass niedrige Zusammenhänge mit allen anderen aufweist ist ungeeignet für eine Skala, denn man kann davon ausgehen, dass es etwas anderes misst als die übrigen Items.

Abb.17